Chapitre VI

Le changement climatique

C’est l’élément clé du débat politico-écologique actuel et la cause principale de la peur écologique.

J’aurais voulu centrer mon exposé sur les deux points, pratiques, qui me paraissent essentiels, à savoir :

1) En admettant l’existence de l’effet de serre d’origine anthropique, quelles peuvent en être les conséquences pour l’homme et la société ?

2) En tenant compte des échelles de temps en jeu, quelle est la meilleure manière de réagir ?

Mais dans le contexte actuel, ce sujet ne peut être abordé sereinement sans parler de l’ambiance d’hystérie catastrophiste, et de dictature intellectuelle, dans laquelle nous sommes baignés, ce qui m’oblige à préciser ma position sur le problème scientifique lui-même. Même si, on le verra, la stratégie d’action que je propose est très équilibrée.

1) Je doute que le gaz carbonique d’origine anthropique soit, dans un système aussi complexe que l’atmosphère, l’unique responsable du changement climatique. Je crois que les causes sont multiples, dont beaucoup sont naturelles (le soleil, le cycle de l’eau, notamment).

2) J’ai peine à croire qu’on puisse prédire avec précision le temps qu’il fera dans un siècle alors qu’on ne peut pas prévoir celui qu’il fera dans une semaine.

3) Je ne pense pas que la notion de température moyenne de la terre soit un paramètre valable pour décrire le climat, tant la variabilité géographique est considérable.

Mais je ne défends pas pour autant l’idée que la croissance du CO2 dans l’atmosphère terrestre est une bonne chose ou même une chose négligeable pour l’humanité. Je crois que l’acidification de l’océan qu’elle provoque d’une part, l’accroissement des teneurs en CO2 dans l’atmosphère des villes, voire son rôle additif dans le changement climatique, d’autre part, sont des phénomènes nuisibles. Je travaille moi-même sur la question de la séquestration du CO2 (sur laquelle nous reviendrons), preuve que je la considère comme importante.

Je pense donc qu’effectivement il y a un changement climatique, mais essentiellement d’origine naturelle et dont on ne peut prévoir l’évolution de manière précise.

J’appellerai désormais Global Warning (GW) la théorie actuellement « à la mode » suivant laquelle le changement climatique serait essentiellement caractérisé par un réchauffement dont l’origine serait principalement humaine et le facteur dominant le gaz carbonique.

Sur ce sujet, ma position a évolué.

Il y a quinze ans, j’ai cru de bonne foi ce que disaient les partisans du GW et je l’ai écritxxviii. Le temps passant, j’ai commencé à m’y intéresser de plus près, à lire des articles originaux, à échanger des opinions avec les spécialistes du domaine, tout cela m’a conduit à douter de certains des raisonnements et des conclusions actuellement en vigueur.

Je dirai même que plus je discute avec les « experts », plus j’ai des doutes sur leurs méthodes et leurs résultats !

Je ne suis pas moi-même météorologue, ni climatologue au sens strict du terme (bien que j’aie publié deux articles sur l’origine des nuages et un certain nombre sur l’influence du CO2 sur les climats passés par l’intermédiaire des fleuves), mais je crois que ma familiarité avec les phénomènes naturels et ma pratique de la physique particulière qui les gouverne me permettent de me faire une opinion sur les divers arguments scientifiques avancés pour et contre, car les raisonnements ne sont pas différents de ceux utilisés en géophysique et en géochimie.

L’effet de serre

Laissons parler les observations, et examinons d’abord le système atmosphérique, auquel on peut sans peine appliquer le qualificatif d’hyper-complexe.

Rappelons tout d’abord le mécanisme de l’effet de serrexxix.

La Terre est éclairée par le Soleil essentiellement dans un domaine de longueurs d’ondes qu’on appelle visible car il impressionne notre œil. Une moitié de ce rayonnement solaire « traverse » l’atmosphère et parvient jusqu’au sol. Ce sol, chauffé, réémet à son tour un rayonnement, dirigé vers l’espace. Mais ce rayonnement est invisible, il appartient au domaine de l’infrarouge.

Ce rayonnement infrarouge ne « retourne » que très partiellement dans l’espace, car l’essentiel est absorbé puis réémis par la basse atmosphère, surtout vers le sol. Ce mécanisme est un peu analogue à celui qui se produit dans une serre de jardinier où le verre laisse passer les rayons solaires mais bloque les rayonnements infrarouges réémis par le sol ou le feuillage des plantes et empêche ainsi l’air chauffé de s’échapper vers l’extérieur. C’est pourquoi on l’appelle (un peu abusivement) effet de serre.

S’il n’y avait pas d’effet de serre, la température de surface du globe serait de -18 °C alors qu’elle est en moyenne + 15 °C. C’est donc un phénomène climatique essentiel que personne ne met en doute.

Quels sont les mécanismes physiques responsables de cet effet de serre ?

C’est là que la difficulté commence, car ces mécanismes sont multiples et complexes. Alors que l’atmosphère est un mélange d’azote et d’oxygène, une série de gaz mineurs absorbent le rayonnement infrarouge pour le réémettre. Quels sont ces gaz ? L’eau d’abord, qui est de loin le plus important gaz à effet de serre (ce qu’on oublie trop souvent). L’eau se trouve dans l’atmosphère soit à l’état de vapeur d’eau disséminée, soit dans ces structures organisées que sont les nuages (où l’eau est à la fois à l’état de vapeur et de gouttes liquides). Les teneurs en eau de l’atmosphère varient beaucoup avec la géographie. Elles sont de 4 % en moyenne dans la zone intertropicale et inférieures à la partie par million au pôle Sud !

Puis des gaz en quantités très faibles, comme le gaz carbonique CO2 dont l’abondance se mesure en parties par million (ppm), 380 ppm, soit 0,038 % ! Le méthane (CH4), 1,7 ppm, l’oxyde d’azote, 0,3 ppm, et l’ozone, encore moins abondant, 0,01 (à la surface).

Mais les gaz n’ont pas l’exclusivité de l’effet de serre.

Interviennent en outre les nuages, dont le rôle est variable suivant le type de nuagesxxx. Il y a ceux qui favorisent l’effet de serre et ceux qui le contrarient en réfléchissant les rayons lumineux. Il y a aussi le rôle des poussières et des aérosols d’origines naturelle, industrielle ou agricole. Il y a en particulier les aérosols et les composés soufrés. Toutes ces particules ont tendance à refroidir l’atmosphère directement, mais aussi à être des « initiateurs » de nuages donc à la refroidir encore plus. Or, comme l’écrit le spécialiste Jean-Pierre Chalon : « Ce rôle des nuages est essentiel puisque l’impact global des nuages sur le bilan radiatif de la planète est 40 fois supérieur aux variations attribuées au gaz à effet de serre enregistrées ces dix dernières années. »

Or, on sait mal estimer la manière dont se forment les nuages, et plus encore quelle est la proportion de cirrus (favorables à l’effet de serre) et de stratus (défavorables). Car ce sont des processus très complexes où interviennent l’état de l’eau, mais aussi les poussières.

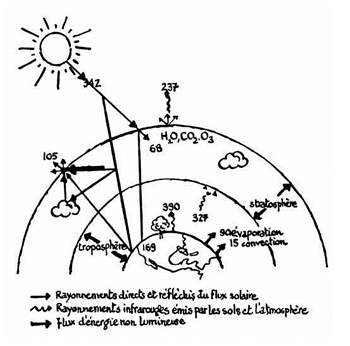

Tous ces paramètres interagissent les uns sur les autres dans des boucles de contre-réactions complexes, tout réagissant sur tout (ou presque). Mais les interactions vont tantôt dans un sens tantôt dans l’autre ; parfois elles réchauffent, parfois elles refroidissent, parfois elles amplifient un effet, parfois elles l’amortissent (un schéma simplifié est déjà complexe ! voir Fig. 1).

Fig. 1. Schéma très simplifié résumant l’effet de serre d’après Yves Lenoir.

Naturellement, la géographie module cet effet de serre car le rayonnement infrarouge émis par les continents, l’océan ou la neige n’est pas le même.

Ce système est en fait encore plus complexe car l’atmosphère n’est pas isolée, elle est couplée avec l’océan (qui rappelons-le occupe les deux tiers de la surface du globe). Elle est couplée mécaniquement. Ce sont les vents qui orientent les courants marins de surface. Elle est couplée thermiquement, en particulier par les échanges d’eau et par contact. C’est la température de l’océan qui détermine la quantité d’eau qui s’évapore et va s’incorporer dans le cycle de l’eau, mais c’est l’atmosphère qui par ses vents et ses nuages contribue à déterminer la température de surface de l’eau qui à son tour réchauffe ou refroidit l’atmosphère. Or, l’océan se chauffe et se refroidit lentement alors que l’atmosphère réagit plus vite. L’océan est donc un modérateur pour la fantasque atmosphère. L’océan qui absorbe ou rejette du CO2, en fonction des lois physiques et chimiques, mais aussi de l’activité photosynthétique de ses algues et de son plancton. Il joue donc un rôle essentiel dans le cycle du carbone.

En outre ces deux réservoirs terrestres ont comme caractéristiques d’êtres animés de mouvements complexes turbulents. Pour l’atmosphère, c’est la circulation des vents. Pour l’océan, ce sont les courants marins horizontaux mais aussi verticaux car l’eau de mer, froide et salée, tombe vers le fond.

Chaque milieu répond à une perturbation avec sa vitesse propre. Une modification imposée à l’atmosphère induit une réaction dont la durée se mesure en quelques mois ou quelques années au maximum. Ainsi, si une éruption volcanique injecte dans l’atmosphère des poussières, celles-ci perturberont toute l’atmosphère en quelques semaines. Cette modification durera deux ou trois ans car les poussières, finalement, retomberont. Les mouvements dans l’océan sont beaucoup plus lents. Pour qu’une perturbation ayant eu lieu à la surface se mélange bien, il faut des durées qui se mesurent en centaines voire en milliers d’années. Ainsi, une eau de surface, qui plonge vers les profondeurs au sud du Grønland, mettra deux mille ans pour faire le tour de la Terre en profondeur puis en surface. L’atmosphère et l’océan échangent des gaz et de la chaleur. En termes savants, on dit qu’ils sont couplés. Le système combiné atmosphère-océan « réagit » à une perturbation avec des durées qui sont intermédiaires entre celles qui concerneraient l’océan ou l’atmosphère seuls. L’estimation de ce qu’on appelle les « temps de réponse » est difficile à déterminer et débattue entre spécialistes. Ainsi, si on modifie brutalement la teneur en CO2 de l’atmosphère, ce gaz modifiera le comportement de cette enveloppe gazeuse en des durées qui vont de 50 à 200 ans. Ce délai, assez long, vient de l’influence de l’océan.

Tout cela conduit à des phénomènes très compliqués, encore insuffisamment compris.

Ainsi, dans le Pacifique, l’interaction océan-atmosphère crée le phénomène qu’on appelle El Nino (ou du terme savant ENSO) qui consiste en une oscillation est-ouest des courants marins équatoriaux, ce qui signifie des changements météorologiques brutaux. Or la fréquence des oscillations est variable, sans qu’on en comprenne bien les causes.

Dans l’Atlantique, tout le monde connaît le fameux courant du Gulf Stream qui selon les théories classiques serait responsable de la température clémente de la France et de l’Espagne. Pourtant cette théorie est aujourd’hui entièrement remise en cause ! Le Gulf Stream ne serait en rien responsable du climat de l’Europe de l’Ouest ! Débat entre spécialistes comme c’est le cas dans une science vivante ! Mais, à ce jour, pas de vérité officielle.

Lorsqu’il s’agit du CO2, il faut bien sûr y ajouter la biosphère, car le trio photosynthèse-respiration-fermentation est l’élément essentiel dans le cycle du gaz carbonique, mais aussi du méthane (les ruminants dégagent du méthane par certains de leurs orifices !).

Et puis il ne faut surtout pas oublier que celui qui fournit l’énergie de tout ce système c’est le Soleil, maître de tout. Or, la distance de la Terre au Soleil varie et le Soleil lui-même est capricieux, instable, et a une activité changeante. L’influence du chauffe-eau de la Terre est variable !

Ce système passablement complexe est perturbé par l’homme qui émet des gaz à effet de serre, CO2, CH4, mais aussi des poussières, des aérosols, des gaz soufrés, et sans doute aussi de l’eau.

Quelle est l’influence de l’homme sur le système climatique ? Pour obtenir une réponse fiable, il faudrait déjà bien connaître le fonctionnement du système dans les conditions « naturelles » et à partir de là apprécier les modifications observées qu’on peut attribuer à l’homme !

De la météo à la climato

Le fonctionnement de l’atmosphère étant responsable du temps qu’il fera demain, l’étude de ses variations a depuis longtemps été l’objet d’une attention particulière. La prévision-météo est un exercice vieux comme le monde, mais son caractère rationnel et scientifique ne date que de moins d’un siècle.

Pendant longtemps, cette prédiction scientifique s’est effectuée à partir de séries temporelles d’observations, la température et la pluie puis plus tard la pression étant les paramètres le plus souvent mesurés. C’était la météo « classique ».

Sont apparus vers les années 1970 deux outils extraordinaires : les ordinateurs et les satellites d’observation.

Par sa capacité à maîtriser rapidement des calculs compliqués, l’ordinateur a fait penser aux météorologues qu’on pourrait simuler le comportement de l’atmosphère donc naturellement prévoir les changements futurs. Au fur et à mesure des progrès des ordinateurs, on a pu ainsi compliquer de plus en plus les programmes informatiques pour rendre compte de mieux en mieux de la réalité… jusqu’à une certaine limite.

Les satellites d’observation ont apporté aux météorologues des moyens d’observation extraordinaires, car on a pu grâce à eux avoir une image globale, mondiale, de l’état de l’atmosphère, avec notamment la répartition des nuages, leurs mouvements, leurs modifications. Avec les progrès des techniques spectroscopiques, on a pu mesurer divers paramètres, la température, la vapeur d’eau ou le gaz carbonique.

La science météorologique a fait ainsi des progrès considérables. Certains ont même cru pouvoir annoncer que, à mesure que la puissance des ordinateurs croîtrait, ou pourrait prévoir le temps à une semaine, puis un mois, puis un an à l’avance.

Malheureusement, patatras, cette ambition s’est effondrée !

Elle s’est effondrée, parce qu’un météorologue du MIT, Edward Lorenz, avait à partir de 1960 entrepris des expériences numériques et montré que la météo était un système chaotique. L’évolution du temps en un point dépendait de petits détails insignifiants. Pour illustrer ce phénomène, il utilisa une image frappante : le vol d’un papillon en un lieu changerait le temps qu’il ferait six mois plus tard au même endroit ! C’est ce qu’on appelle l’effet papillon.

Les météorologistes eurent d’abord du mal à le croire, car Edward Lorenz avait, pour le comprendre, simplifié beaucoup le problème. Pourtant, petit à petit, grâce au soutien qu’apporta à Edward Lorenz le « pape » de la météorologie Jules Charney, la vérité s’imposa, à la fois par l’expérience quotidienne et par les calculs : on ne peut prévoir le temps que trois ou quatre jours à l’avance. Ce sont les phénomènes physiques eux-mêmes qui créent cette complexité et cette incertitude dans le futur. Avoir des ordinateurs plus puissants pour simuler le système n’améliorera pas pour autant la prévision. L’incertitude dans l’avenir est intrinsèque au phénomène météo lui-mêmexxxi.

C’est à ce moment qu’il faut introduire la notion de climat. Le climat est un état difficile à définir rigoureusement. C’est l’ensemble des conditions externes moyennes qui règnent en un lieu pendant une durée qu’on fixe généralement à trente ans.

Parmi ces paramètres, il y a la température, l’ensoleillement (lié mais distinct de la température), la pression, la pluviosité, le vent. Mais ces paramètres doivent être envisagés à la fois du point de vue d’une valeur moyenne et de celui de sa variabilité (par exemple, le contraste entre les étés et les hivers, etc.).

Cette notion a été définie par les géographes ; et la plupart des premiers climatologues étaient des géographes. Ce sont eux qui ont défini les divers types de climats que l’on observe sur le globe (désertique, boréal, continental, tempéré, marin, tropical, etc.).

Munis de leurs programmes d’ordinateurs surpuissants pour la prévision du temps, les météorologues, et en particulier ceux appartenant aux grands services météorologiques du monde se sont transformés à partir des années 1980 en climatologues. Ils avaient une stratégie en tête : utiliser leurs gros programmes informatiques en les adaptant pour contribuer à expliquer les climats.

L’objectif n’était plus de s’intéresser aux conditions météo journalières, mais aux moyennes décennales, en particulier celles de la température et de la pluviosité, puisque aussi bien ce sont les paramètres principaux du climat.

L’hypothèse de base était de considérer que certes le système météo est chaotique à l’échelle du mois ou de l’année (ce qui par parenthèse rend caduques toutes les considérations annuelles qu’on entend ici ou là), mais qu’à l’échelle de dix ans on peut calculer des moyennes significatives dont on peut prévoir l’évolution.

Pendant que les labos de météo mettaient au point ces modèles informatiques, ce qui demande pas mal de travail et d’astuces d’informatiques ou d’analyse numérique, se développaient d’autres recherches passionnantes sur le climat. Il s’agissait cette fois de reconstitution des climats passés de l’ère quaternaire en utilisant un thermomètre fossile : la mesure des rapports isotopiques 18O/16O. On a pu utiliser ce thermomètre à la fois sur des carottes de sédiments prélevées au fond des océans et sur des carottes de glace forées au milieu du Grønland et du continent antarctique. Ces études très remarquables, dans lesquelles les groupes européens de Cambridge et de Gif-sur-Yvette pour les sédiments, de København, de Berne et de Grenoble pour les archives glaciaires ont joué un rôle primordial, ont permis une reconstitution assez précise des climats passés pour le dernier million d’années.

Ces diverses études portant sur les climats se sont intéressées très vite au rôle du gaz carbonique (CO2) dans le déterminisme du climat. Cette hypothèse avait été faite par le chimiste suédois Arrhenius à la fin du XIXe siècle et depuis 1959 un observatoire installé au sommet du Mona Loa, à Hawaii, avait montré que la teneur en CO2 de l’atmosphère avait augmenté sans cesse depuis cette date.

Le scénario du « Global Warning »

C’est à partir de ces diverses études qu’a émergé le scénario GW.

Voyons comment il est « classiquement » présenté dans les articles de revue et les livres écrits sur le sujet depuis une quinzaine d’années.

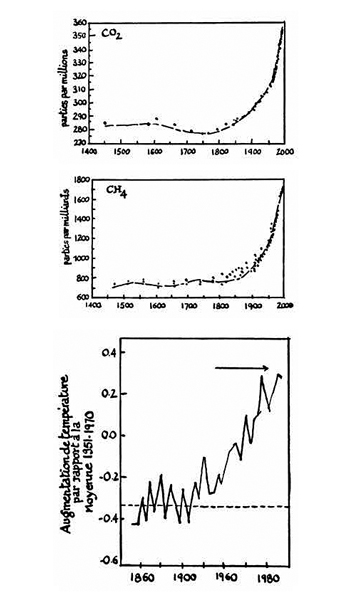

Première étape du raisonnement : depuis 1958 on a observé une augmentation continue des teneurs en CO2 de l’atmosphère : de 280 ppm elles sont passées à 380 ppm. Cette augmentation est attribuée à la combustion des charbons, du pétrole et des feux de forêts. En utilisant les archives glaciaires on a pu déterminer une courbe d’augmentation du CO2 et du méthane depuis le début du siècle.

Fig. 2. Les « trois courbes » :

— En haut, augmentation de la teneur en CO2, de l’atmosphère depuis le XVe siècle.

— Au milieu, augmentation de la teneur en méthane CH4 pour la même période. Les teneurs du XVe au XIXe siècle ont été déterminées par l’analyse des bulles d’air emprisonnées dans les couches de glace du Grønland.

— En bas, la courbe dite de Jones, montrant les augmentations de température depuis 1860. Cette courbe est aujourd’hui fortement mise en doute.

On a donc étudié la variation de température de la basse atmosphère depuis la fin du XIXe siècle. En compilant le données disponibles, un peu partout dans le monde, on établi une courbe traduisant l’évolution de la température moyenne du globe de 1850 à 2000. Cette courbe désormais « classique » semblait montrer une augmentation de températures régulière de 0,6 °C de 1880 à 2000.

À partir de ces deux courbes, le raisonnement est du coup devenu simple et massif.

La température moyenne du globe a augmenté parallèlement aux teneurs en CO2, et CH4 de l’atmosphère, c’est bien la preuve que le CO2 et le CH4 sont les gaz responsables de l’augmentation des températures par effet de serre ! L’homme modifie donc le climat.

Le second argument pour affirmer le rôle du CO2, qui traîne lui aussi dans les livres, est celui des archives glaciaires. On sait que les calottes glaciaires du Grønland et de l’Antarctique sont constituées par l’empilement de couches annuelles. En effectuant un forage dans ces calottes glaciaires, on récupère des carottes qui sont les archives de l’histoire des chutes de neige et aussi de la composition chimique des atmosphères emprisonnées dans la glace sous forme de bulles.

Les études des paléotempératures de la glace, et des teneurs en CO2 des bulles, ont montré que ces deux paramètres variaient de manière concomitante. C’était la confirmation que le CO2 était bien la cause essentielle des variations de température du globe. C’était d’autant plus vrai qu’à cette époque, l’homme n’était pour rien dans leur émission. Ces deux observations semblaient établir que le CO2 jouait le rôle essentiel dans le déterminisme du climat. On pouvait donc passer à la seconde étape.

Seconde étape : on entre dans le gros programme informatique, les variations des teneurs en CO2 observées depuis 1885 et, après quelques ajustements, on reproduit l’augmentation de 0,6 °C de la température observée depuis le XIXe siècle.

On considère que les « ajustements » sont valables et donc on extrapole. On calcule alors ce que seraient les températures moyennes dans un siècle si on doublait au rythme actuel les teneurs en CO2 de l’atmosphère. Suivant le détail des modèles, on obtient entre 1 et 6 °C d’augmentation.

La naissance du doute

Or, depuis maintenant au moins cinq ans, on sait que la première partie du raisonnement est fausse.

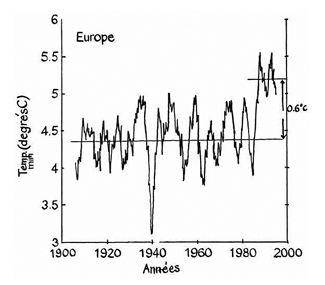

Fig. 3. Courbe d’évolution des températures en Europe depuis 1900, obtenue par Jean-Louis. Le Mouël, Héléna Blanter et Michael Schnirmann.

On notera l’existence claire d’oscillations et l’augmentation brutale en 1987.

La courbe d’augmentation de température de ce qu’on connaît bien, à savoir l’Europe, depuis 1850 n’est pas une courbe à croissance continue comme on l’a dit, mais une courbe fluctuante autour d’une valeur moyenne, avec une augmentation assez brutale depuis 1987 de 0,6 °C. Et depuis lors des fluctuations autour de cette valeur. C’est ce qu’ont établi mes collègues Jean-Louis Le Mouël, Héléna Blanter et Michael Schnirmann, des Instituts de physique du globe de Paris et de Moscou, en se concentrant sur les données européennes, de loin les plus fiables (et sans doute les seules !).

Que veut dire température moyenne du globe définie à 0,1 °C près au XIXe siècle ? L’établissement d’une telle courbe est sujet à des erreurs de statistiques considérablesxxxii, une surestimation des incertitudes sur les données du XIXe siècle, qui n’étaient ni assez nombreuses ni assez précises pour définir des températures moyennes à 0,1 °C près alors que les incertitudes de chaque mesure excédaient 2 °Cxxxiii !

Quant à la co-variation température-CO2 dans les glaces, une étude américano-française en 2003xxxiv a montré que les variations de la température précédaient de huit cents ans celles de CO2.

Ce n’est donc pas le CO2 qui fait varier la température, c’est l’inverse !

Il ne restait donc pour affirmer le GW et le rôle primordial du CO2 que la seconde partie, la simulation sur ordinateur.

C’est ce que dit Hervé Le Treut, directeur du laboratoire de météorologie dynamique. On annonce un réchauffement climatique parce que les modèles informatiques le prédisent !

Mais là, il y a un hic ! C’est le contenu des modèles informatiques.

Quand on constate l’absence des évidences phénoménologiques sur le rôle cardinal du CO2, pourquoi le lui donner dans les modèles ?

Sous le prétexte que l’on connaît bien la courbe d’évolution des teneurs de CO2 dans l’atmosphère, on fait jouer au CO2 le rôle majeur.

Et le bon sens peut ajouter : « Comment un système si complexe que le climat aurait-il comme seul facteur cardinal le CO2 dont la teneur est 300 parties par million ? N’est-ce pas parce qu’on connaît bien ses variations récentes qu’on lui attribue l’unique responsabilité ? Comme on ne sait pas bien comment se forment les nuages, on les néglige ! Comme on maîtrise mal le rôle des aérosols et des poussières, on les néglige ! Alors que ces facteurs peuvent être quantitativement déterminants ! N’est-ce pas comme le fameux paradigme de celui qui cherche ses clés sous le réverbère parce que c’est la zone où il peut les chercher ? »

Le raisonnement scientifique nous suggère l’incertitude, l’ordinateur nous prédit avec certitude l’avenir ! Que choisir ?

Que peuvent faire le raisonnement, la logique et l’intuition d’un pauvre cerveau humain face à la puissance des plus gros ordinateurs du monde ?

En apparence rien, en réalité tout ! « Il peut comprendre ! » Ce que ne fera jamais l’ordinateur. Et je le dis avec toute ma conviction.

Rien ne remplacera jamais en science l’observation de la nature et sa mesure ! « La seule vérité en science est donnée par les observations », disait Henri Poincaré, pourtant lui-même théoricien.

C’est aussi mon avis !

Bien sûr, on ajuste ces modèles informatiques pour qu’ils rendent compte en gros des observations actuelles et passées sur le climat. Mais c’est « en gros » : nous y reviendrons.

Comme l’écrit un climatologue, lui-même auteur de ces modèles, Dennis Hartmann : « Les simulations obtenues avec les modèles sont en accord raisonnable avec les observations essentielles du climat actuel… Cet accord est un encouragement, mais il ne signifie pas que nous sommes capables de prédire de manière précise toutes les réponses aux forçages naturel ou anthropiquexxxv. » On ne peut mieux dire !

Le changement climatique

Pendant que ces modèles se développaient, la réalité d’un changement climatique pour les années récentes est apparue d’une manière que je crois incontestable. Il se caractérise par :

• Une augmentation de la fréquence et de l’intensité des phénomènes extrêmes. Il semble, par exemple, que les épisodes pluvieux soient plus brefs et plus intenses et les épisodes de sécheresses aiguës ou de vagues de chaleur (canicules) plus fréquents. Cela conduit de manière paradoxale à une multiplication simultanée des inondations ici et des périodes arides là, préjudiciables à l’agriculture. À première vue, les cyclones tropicaux des Caraïbes semblent plus forts, plus intenses, ceux d’Asie du Sud-Est plus nombreux, les tempêtes violentes de l’Atlantique Nord plus fréquentesxxxvi.

• Une observation pour moi essentielle de ce changement est la variabilité géographique qui caractérise ce changement. Nous avons eu une illustration spectaculaire de ces effets locaux lorsque, en janvier dernier, la moitié des États-Unis était sous la neige, en particulier la Californie, le Texas, l’Arizona, le Colorado, alors qu’il régnait une température printanière à New York et Boston qui, eux, avaient eu droit à de la neige au mois de septembre.

Les études de températures concernant le dernier siècle, en Europe, montrent des contrastes étonnants. La température est stationnaire en Allemagne alors qu’elle augmente en Suisse. À Sankt-Peterbourg et à Arkhangel’sk, les évolutions récentes sont en sens opposé.

On se souvient de ces étés où il se produit une sécheresse en Grèce et des inondations en Autriche, etc. Cet aspect a été totalement négligé, parce que les modèles numériques n’ont pas la capacité de bien reproduire ces phénomènes locaux. Ils sont pourtant essentiels. Lorsque l’hiver est clément à Moscou, on pointe du doigt le réchauffement climatique. Mais lorsque, l’année dernière, une vague de grand froid sans précédent a sévi, on l’a passée sous silence. Et pourtant, l’un et l’autre sont parties prenantes intégrales du processus de changement climatique.

Il faut donc éviter de fonder les prédictions du climat futur sur une moyenne mondiale dont la situation est floue. Il faut faire des prédictions régionales, comme je le dis depuis dix ans !

• Les glaciers de montagne sont en régression dans les Andes et dans les Alpes. Pourtant, les glaciers scandinaves ne reculent pas.

• L’Arctique et le Grønland voient leurs glaces fondre et le volume de glace diminuer. Mais ce phénomène ne se produit pas en Antarctique qui stocke pourtant 92 % de la cryosphère.

• Des observations précises faites à l’aide du satellite Topex-Poséidon mettent en évidence une montée du niveau de la mer. Cette dernière est toutefois modeste, 3,2 millimètres par an soit 32 centimètres par siècle.

Cela n’a rien à voir avec les 6 mètres avancés par Al Gore qui prend l’hypothèse irréaliste et non fondée sur des observations actuelles d’une fonte totale des glaces du Grønland, qui en réalité demanderait mille ans !

Propagande et réalités

Toutes ces observations attestent qu’il y a bien eu un changement climatique, et peut-être même un réchauffement depuis 1987 si l’on se fie aux observations sur les températures européennes et sur la montée du niveau de la mer. Mais aucune de ces observations ne lie automatiquement cela au gaz carbonique d’origine humaine ! Nuance !

Montrer ces phénomènes spectaculaires à la télévision à l’aide de magnifiques reportages, ou dans un film comme le fait Al Gore, et affirmer qu’il y a là la preuve de l’influence de l’homme sur le climat est une imposture intellectuelle, une escroquerie ! Où est la démonstration de l’influence de l’homme sur le climat ?

Car ces changements climatiques récents ne sont pas uniques, ni exceptionnels dans l’histoire. Ils se placent dans une longue série de fluctuations climatiques, tant géologiques qu’historiques. Les climats du globe ont toujours varié, et bien avant que l’homme ne soit devenu ingénieux ou même qu’il existe !

Songeons qu’il y a 700 millions d’années, la Terre a été entièrement recouverte de neige et de glace ! Songeons qu’il y a 180 millions d’années, l’océan recouvrait la moitié de l’Afrique de l’Ouest. Songez qu’il y a 65 millions d’années, une énorme éruption volcanique en Inde fut le principal responsable d’une extinction énorme des espèces, dont les fameux dinosaures.

Plus près de nous, depuis 4 millions d’années, se sont succédé les fameuses périodes glaciaires et interglaciaires. Les études faites à partir des carottes de glace ont montré que, concomitamment aux tendances générales, il y eut des phénomènes brutaux, brefs, mais qui étaient opposés à la tendance générale. Ces événements, qu’en jargon de spécialistes on appelle H ou D-0, sont majoritairement présents dans l’hémisphère Nord au Grønland, et faibles ou absents en Antarctique. Pourquoi ? On n’en sait rien.

Pour les périodes historiques, excellemment explorées, notamment en France par Emmanuel Le Roy Ladurie, il y eut plusieurs épisodes. Au Moyen Âge une période chaude qu’on appelle l’optimum climatique médiéval (que croyez-vous que signifie Grønland en danois ? pays vert). Suivit une période froide, « le petit âge glaciaire », entre le XVIe et le XIXe sièclexxxvii. Dans ce dernier cas, des événements brutaux, brefs, chauds, donc opposés à la tendance générale, se sont produits, dont certains ont fait des milliers de morts (1719 : 450 000 morts ; 1706 et 1747 : 200 000 morts).

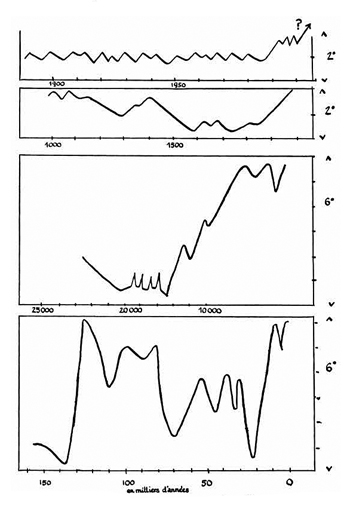

Fig. 4. Les courbes sont destinées à montrer les fluctuations de température de l’atmosphère terrestre sur quatre échelles de temps. Les deux courbes intermédiaires sont en années. La flèche sur la courbe du haut représente l’hypothèse GW.

Question logique : est-ce que les modèles sur ordinateur rendent compte de ces observations ?

Oui et non. En gros oui, sinon, bien sûr, on ne les présenterait pas comme des éléments de preuves ! En détail, non !

Ces modèles prétendent que les facteurs de forçagexxxviii naturels (soleil, éruptions volcaniques) permettent de reconstituer l’évolution de la température moyenne jusqu’en 1975, mais qu’ensuite ils n’y arrivent plus. Pour expliquer l’augmentation de température de 0,5 °C observée depuis 1987, il faut, d’après eux, obligatoirement ajouter le rôle majeur du CO2 ! Est-ce sûr ?

Les modèles informatiques indiquent un réchauffement aux pôles, un accroissement des précipitations dans les tropiques, une désertification croissante de l’Afrique saharienne. En revanche, ils ne parviennent pas à simuler l’augmentation des phénomènes extrêmes et brutaux ni à expliquer pourquoi l’Antarctique ne fond pas et les températures du Grønland n’augmentent pas alors que la glace y fond. Certes, les programmes informatiques dessinent de belles cartes en couleurs, des prévisions des pluies, mais d’une manière très imprécise. Ils affirment par exemple que la France du Nord sera plus humide et la France du Sud plus sèche, mais définissent la frontière entre les deux zones à 1 000 kilomètres près !

Donc, dans le détail, les modèles n’expliquent pas tout. Lorsqu’on les applique aux climats passés tels qu’on les enregistre dans les carottes glaciaires, si les modèles reproduisent bien les alternances glaciaires-interglaciaires (mais Milankovitch, sans ordinateur, le faisait déjà), ils sont incapables de reproduire les événements brutaux qui se passent pendant les grandes périodes qu’on appelle en jargon glaciologique D-0 ou H.

Les critiques du GW

Par rapport à ces modèles, diverses critiques se sont fait jour. Car, contrairement à ce qui est dit, l’unanimité est loin de régner dans la communauté météo-climatologique, et encore moins quand des scientifiques extérieurs à la communauté s’intéressent à ce problème.

Pour ce qui concerne la communauté météo-climatologique, j’ai choisi trois personnalités parce qu’elles me paraissent représentatives d’un doute qui, à mon avis, se généralisexxxix :

Richard Lindzen, professeur de météorologie au MIT, l’un des plus jeunes scientifiques élus à l’Académie des sciences des États-Unis.

Fred Singer, professeur à l’université de Virginie, ancien responsable des observations météorologiques par satellites de la Nasa.

Marcel Leroux, professeur de climatologie à Lyon.

Je ne puis énumérer ici toutes leurs critiques ou réserves qui sont nombreuses. J’ai décidé de choisir celle qui, pour chacun, me paraît la plus signifiante.

Tous trois défendent une même idée, à savoir que les variations climatiques observées sont d’origine naturelle et que l’homme n’y est pas pour grand-chose.

Richard Lindzen estime que toutes les rétroactions et interactions naturelles, et en particulier celles qui sont liées aux nuages et aux aérosols dont l’origine peut être naturelle ou humaine (agriculture, industrie), sont suffisantes pour expliquer la légère augmentation récente de la température. Il fait remarquer que les variations dont nous parlons sont très faibles. Les températures se mesurent en kelvins et la température de surface est en moyenne de 288 kelvins. Une variation de 0,6 °C correspond à une variation de 2 pour mille dans un système très complexe où les interactions sont multiples et où, par exemple les nuages et la vapeur d’eau – dont on maîtrise mal la logique de comportement – ont pourtant le rôle essentiel.

Fred Singer fait remarquer que le réchauffement observé au Moyen Âge était plus important que celui d’aujourd’hui. Or, comme on l’a mesuré dans les archives glaciaires, le CO2 de cette époque n’était pas particulièrement élevé. La cause de cet épisode chaud était autre que le CO2. Pourquoi aujourd’hui le léger réchauffement ne serait-il pas dû aux mêmes causes naturelles ?

Marcel Leroux a publié une critique très documentéexl dont nous retiendrons un aspect qui peut être compris par des non-spécialistes. Il remarque que la différence de température entre les pôles et les tropiques est le paramètre climatique fondamental. Plus cette différence est forte, plus il y a de tempêtes. C’est pourquoi les tempêtes ont lieu plus fréquemment en hiver qu’en été. Or, les modèles de réchauffement prédisent une atténuation de ce gradient Nord-Sud (la température augmente beaucoup aux pôles, faiblement à l’équateur). Ce qui devrait induire un affaiblissement des phénomènes extrêmes. Or, on observe une amplification de ces phénomènes. Il fait aussi d’autres remarques plus techniques, mais tout aussi intéressantes.

Jean-Louis Le Mouël, Vincent Courtillot, Héléna Blanter et Michael Schnirmann, mes collègues, experts en traitement des séries temporelles, ont étudié avec soin les séries historiques de températures à l’aide de « traitements du signal » élaborés et en ont conclu que le paramètre essentiel des variations est le Soleil et ses fluctuations, dont on connaît bien les vicissitudesxli. Ce qui rejoint des travaux déjà anciens des astronomes spécialistes du Soleil.

Hors de la communauté étroite des météorologues modélisateurs (rebaptisés climatologues), chaque fois que quelqu’un s’est penché sur le problème en examinant les arguments, en comparant les résultats des modèles avec les observations, les proclamations avec les faits, le doute s’est instauré. N’est-ce pas étrange ?

Citons-en quelques-uns : l’ingénieur Yves Lenoir, du CEA, qui a écrit deux livresxlii sur le sujet ; l’ingénieur Hermann qui a exprimé ses doutes dans le journal des anciens élèves de l’École polytechnique après une analyse objective du problème.

Cette attitude intellectuelle de doute sur la théorie officielle du GW est aussi celle de personnalités d’origine et de formation variées.

Bjørn Lomborgxliii, statisticien danois qui aborda le problème alors qu’il était membre de Greenpeace ; Michael Crichtonxliv, romancier à succès mais qui a une formation scientifique de base acquise à Harvard ; André Fourçansxlv ou Cécile Philippexlvi, économistes, ou encore Pierre Kohlerxlvii, journaliste qui a fait une enquête serrée et semble-t-il sans idée préconçue.

Encore une fois, le débat actuel sur les causes des changements climatiques ressemble beaucoup à l’histoire de la dérive des continents dans laquelle tous ceux qui étaient convaincus par les faits se trouvaient dénigrés au nom des mathématiques et de leur rigueur ! On leur opposait le consensus de la communauté géologique internationale. Et aujourd’hui cette attitude est amplifiée par le mythe de l’informatique toute-puissante : « Puisque l’ordinateur l’affirme, ce doit être vrai. »

Alors, bien sûr, la question qu’un honnête homme peut se poser est : Comment cette théorie du réchauffement climatique dont l’homme serait entièrement responsable a-t-elle réussi à convaincre tout le monde, l’ONU, les milieux politiques, au point de devenir le dogme ? On nous donne comme argument qu’il y a consensus des climatologues pour adopter ce scénario. Et le mot consensus séduit bien sûr les politiques qui, dans leur domaine, en rêvent. Ils ne savent pas que, en science, ce n’est pas un argument. En Californie, les politiques sont tellement convaincus qu’une proposition a même été faite au Sénat de Sacramento suivant laquelle mettre en doute le GW serait un « crime d’État » passible de sanction. C’est pis qu’en France avec la vérité historique établie par vote de l’Assemblée nationale !

Le GIEC

Pour comprendre tout cela, il faut faire un peu d’histoire et de psychologie collective. Rappelons pour commencer les mécanismes du GIEC (Groupement Intergouvernemental d’Étude du Climat).

Tout commença en octobre 1985, à Villach, en Autriche, où fut organisée la première conférence mondiale sur le climat. Les participants réunis là étaient en grande majorité des météorologues néo-climatologues spécialistes des modèles numériques dont on a vu l’évolution historique. Les conclusions de ce groupe affirmaient qu’en 2030, la température du globe aurait augmenté de 1,5 à 6 °C, conduisant à une montée du niveau des mers de 20 à 50 centimètres. À la suite de ces conclusions fut mis en place en 1993, sous l’égide de l’ONU, un groupe international de scientifiques destiné à établir l’état des lieux et à formuler des recommandations aux chefs de gouvernement.

L’idée de rassembler une escouade de scientifiques du monde entier pour connaître l’état du savoir sur une question d’importance sociétale paraît naturelle aux politiques (et même de bon sens). Pourtant elle est déjà, en elle-même, une démarche discutable, si le résultat cherché est de parvenir au consensus plutôt que de conserver la variété des opinions et les incertitudes qui leur sont attachées. Agir ainsi, c’est instaurer la règle de fer du consensus dont nous avons vu l’influence néfaste pour les développements passés de la science, cela d’autant plus que, dans une instance de l’ONU où il faut représenter toute la planète, il y a de fortes chances que les États-Unis et l’Europe, chacun représenté par un petit groupe de personnes, dictent leurs lois. Mais cette démarche a été d’autant plus biaisée que le rapport du groupe de travail se fait en deux étapes : une étape purement scientifique conduisant à un volumineux rapport no 1 de près de mille pages (que personne ne lit !), une seconde étape avec un groupe de représentants des pays (des scientifiques, des fonctionnaires ou des politiques), produisant un rapport no 2 d’une centaine de pages, très compact, destiné aux décideurs et dans lequel on fait naître un consensus en votant ! C’est naturellement le seul qui soit lu par les médias, le public et les décideursxlviii.

Et ceux qui protestent sont éliminés. Ainsi, dans le dernier de ces rapports, on lit que les cyclones tropicaux vont augmenter. Or, Ch. Landsea, spécialiste incontesté de ces phénomènes, avait écrit dans le rapport exactement le contraire. Il a démissionné du GIEC pour « ne pas contribuer à un processus aux objectifs préconçus et scientifiquement non fondés ». Roger Pielke, qui défend l’idée que d’autres facteurs que le CO2 interviennent dans le réchauffement climatique, a vu lui aussi sa contribution totalement modifiée et il a lui aussi démissionné. Si la vérité scientifique s’était décidée par un vote, Galileo Galilei et Albert Einstein auraient été ignorés !

Le premier GIEC a été totalement sous la coupe des services météorologiques des États-Unis et de Grande-Bretagne, le « Chairman », l’Anglais John Houghton, étant la personne la plus influente et qui allait en fait bâtir en grande partie sa réputation scientifique autour de son rapport.

Dès le premier rapport, le GIEC choisit comme stratégie l’alarmisme. Comme le rapport scientifique no 1 était jugé trop nuancé, insistant largement sur les incertitudes, on rajouta sur le rapport final, après les réunions du comité, qu’on « avait constaté l’influence perceptible de l’homme sur le climat globalxlix ». C’était le début…

Le protocole de Kyoto

C’est à partir de là qu’a été organisée la conférence de Kyoto, au Japon, qui devait conduire à la rédaction du fameux protocole. C’est un pur produit de la machine onusienne ! Après le succès déjà évoqué du protocole de Montréal sur le trou de la couche d’ozone, pourquoi ne pas faire de même pour le climat ?

Le protocole de Kyoto qui en résulta est sans doute l’un des traités internationaux les plus absurdes qui aient jamais été proposés.

Il n’a jamais été appliqué, ne le sera jamais et, comme on le voit, on n’arrive pas à réunir une conférence pour faire un Kyoto 2. Pourquoi ? Parce que le rapport coût/résultat est absurdement élevé.

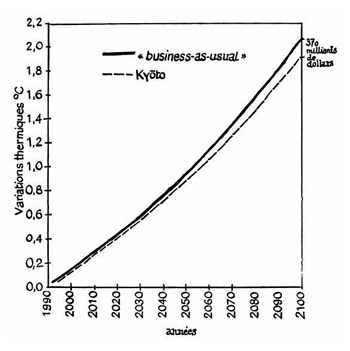

Fig. 5. Augmentations de température :

— sans protocole de Kyoto

— avec protocole de Kyoto.

L’objectif : revenir à 5 % en dessous des émissions de CO2 de 1990. Résultat, d’après les modèles eux-mêmes, réduction de la température de 0,15 à 0,30 °C en 2100.

Le résultat est faible ; quel en est le coût ?

Une réunion s’est tenue en 1999 à Stanford, où se sont retrouvés le gratin des économistes américains et quelques Européens invités. Le coût estimé de Kyoto est 370 milliards de dollars et des millions de chômeurs ! Pour 3 millionièmes de degré de diminution par an, alors que la température entre le jour et la nuit dépasse 10 degrés, n’est-ce pas véritablement absurdel !

De plus, Kyoto propose de mettre en place un système financier de « droit à polluer » octroyé aux pays pollueurs ! Vous êtes riches, vous pouvez polluer, vous êtes pauvres, abstenez-vous, on vous dédommagera pour cela ! C’est absolument scandaleux sur le simple plan de la moraleli !

C’est pourquoi Bill Clinton (avec Al Gore comme vice-président) n’a pas signé le protocole de Kyoto. George Bush n’a fait que suivre son prédécesseur. Mais on l’oublie ; c’est plus commode.

C’est pourquoi ce genre de protocole n’a aucune chance d’être appliqué. La France, très véhémente sur ce sujet, ne l’a pas davantage respecté.

C’est pourquoi enfin, depuis dix ans, on ne fait rien pour prévenir concrètement les effets du changement climatique accroché au totem de Kyoto ! L’obligation de suivre les recommandations du GIEC, c’est le cadeau de départ que font à leurs successeurs les chefs d’État ou de gouvernement. Hier c’était Bill Clinton, aujourd’hui ce sont Tony Blair et Jacques Chirac !

La dictature de l’incertain

C’est à partir de là pourtant que le GW a commencé à « polluer » puis à envahir les médias et le monde politique. Il a bien sûr pour lui la fascination que la prédiction de l’avenir exerce sur les hommes et les princes, les peurs millénaristes, Michel de Nostradamus, Madame Soleil, etc., mais à mon avis, le refus des États-Unis de signer le protocole de Kyoto a été un facteur d’amplification. La haine de l’Amérique, de sa puissance, de sa réussite, a amplifié le mouvement.

« C’est bien la preuve que c’est important, ces salauds d’Américains ont refusé de le signer, c’est bien la preuve que c’est important ! » Aux écologistes se sont joints les antimondialistes et les anti-libéraux !

À cela s’ajoute bien sûr l’attitude d’une petite communauté scientifique dont certains membres se sont intronisés comme les prêtres de l’éco-fondamentalisme. Ils jouent l’alarmisme et le catastrophisme, plus encore dans leurs adresses aux médias que dans les rapports eux-mêmes. De plus, ils contrôlent une partie des publications scientifiques où ils éliminent systématiquement les opposants. Ils attaquent ensuite et dénigrent ceux qui ne pensent pas comme eux. Il est vrai qu’avec cette stratégie de la peur, ils ont multiplié leurs subventions de recherche par cinq, voire dix en dix ans ! C’est cela, la seule action concrète du protocole de Kyoto !

Richard Lindzen a écrit dans le Wall Street Journal un article pour dénoncer ce climat de peur, qui a biaisé entièrement la pratique scientifiquelii. Car il existe une véritable dictature intellectuelle dans le milieu scientifique. On ne fait pas dans la nuance, on accuse Richard Lindzen d’être à la solde d’Exxon, ce qui est totalement faux ; en France, on refuse d’entendre Marcel Leroux sous le prétexte qu’il est géographe-climatologue. Cela ressemble à l’époque où, en économie, tout économiste qui ne faisait pas de grands calculs était méprisé et ignoré par les économistes mathématiciens, et John Keynes pour cette raison ignoré. L’économie est heureusement sortie de cet ostracisme. Tout cela crée une atmosphère nauséabonde qui ressemble par beaucoup de points à l’épisode d’Alfred Wegener. Les mathématiques contre les observateurs ! La dictature des prêtres du climat. Cela rappelle cet l’épisode de l’Antiquité égyptienne au cours duquel les prêtres d’Amon s’étaient octroyé le monopole de la prédiction de l’avenir et supprimaient tous ceux qui mettaient en doute leurs pouvoirs. Et les médias bien sûr d’amplifier tout cela.

En 2007, le GIEC vient de publier son quatrième rapport. Contrairement à la traduction qu’en ont donnée les médias français, il est beaucoup plus modéré que les précédents. Il a abandonné l’argument relation CO2/température des archives glaciaires.

Il modère sans encore l’abandonner l’argument d’évolution de la température depuis le XIXe siècle.

Il reconnaît que le problème le plus préoccupant est la multiplication des phénomènes extrêmes exceptionnels, mais il admet qu’on ne sait pas le prévoir. Il resserre les prédictions sur l’évolution des températures majeures. Pour un doublement des émissions de CO2, la température du globe augmenterait de 2 à 4,5 °C en un siècle. Le précédent rapport disait entre 1,5 et 6 °C. Le scénario le plus probable étant de 2,5 °C. Le niveau de la mer augmenterait de 28 à 48 centimètres (le précédent rapport disait entre 9 et 88 centimètres).

Il cherche enfin à répondre à la critique sur le caractère non signifiant des températures moyennes du globe et cherche à en estimer une série continent par continent.

Du coup, il a été critiqué par des tenants de la stratégie alarmiste, comme par exemple Jim Hansen, directeur du Goddard Center de la Nasa.

Doit-on s’affoler ?

Le bon sens indique que non ! Mais le journalisme d’épouvante se charge de propager l’idée contraire. Alors, on raconte n’importe quoi.

On montre le Kilimandjaro sans neige et l’on pointe du doigt le CO2 et derrière lui l’homme responsable de tout. Or, la disparition des neiges du Kilimandjaro n’est pas due à un réchauffement qui provoquerait la fonte des neiges. Ce phénomène spectaculaire traduit la désertification de l’Afrique, phénomène qui a commencé il y a plusieurs millions d’années et s’est un peu accéléré depuis dix ansliii, et n’a donc rien a voir avec le CO2 d’origine anthropique.

On lit dans Le Journal du dimanche de novembre 2006 une pleine page décrivant comment le réchauffement climatique dû à la pollution créée par les Australiens est en train de submerger un atoll du Pacifique. Cet article illustre l’ignorance totale du journaliste, car la subsidence des atolls est un phénomène connu depuis le XIXe siècle et sur lequel Charles Darwin a abondamment écritliv.

Le journal télévisé de France 2 du 11 janvier 2007 décrit avec rigueur la reprise du phénomène El Nino au Pérou, qui va sans doute provoquer un réchauffement eu Europe, suivant en cela un phénomène naturel encore mal expliqué. Le journaliste se croit obligé d’ajouter, « mais le réchauffement climatique est d’origine humaine » (qu’en sait-il ?).

Soir 3, le 14 janvier, n’est pas en reste. Décrivant la vague de grand froid en Californie, au Texas, alors que le temps est clément à l’Est, le commentateur ajoute : « Les États-Unis payent leur pollution, ils n’ont pas signé le protocole de Kyoto ! » Et le record sera battu par le Paris Match de mi-janvier qui dresse un inventaire partiel d’une catastrophe annoncée : véritable fourre-tout, de l’assèchement de la mer d’Aral (dû à la sur-culture du coton) jusqu’aux atolls du Pacifique, on y décrit comme une calamité le fait que les sols gelés du nord de la Russie seront remplacés par une grande forêt ! Cet article est un tissu d’âneries que je garde précieusement. Et Le Monde surenchérit dans son édition datée du 31 janvier : au milieu d’un article de pure propagande, il est écrit, parmi les prédictions du GIEC, qu’« il y aura peut-être davantage de tsunamis, mais on n’en est pas sûr ! ». Je rappelle que les tsunamis sont créés par les séismes ! Pourquoi ceux qui travaillent sur le climat ne dénoncent-ils pas ce galimatias ? Pourquoi certains d’entre eux se complaisent-ils à affirmer que telle augmentation de chaleur est un indice du GW alors que par définition ils savent que le climat s’évalue sur une moyenne de trente ans et qu’on ne peut prévoir le temps que trois ou quatre jours à l’avance !

Personnellement, je rappelle mes doutes sur la possibilité de prédire le climat à court, moyen ou long terme alors qu’on ne peut prédire le temps qu’il fera la semaine prochaine ni connaître les climats quaternaires de l’hémisphère Nord !

L’idée du GW pur et dur commence à être critiquée. Le prétendu consensus prend l’eau de toutes parts, le GIEC lui-même devient modéré. Les scientifiques qui l’ont proposé et défendu sans nuances sont aujourd’hui sur la défensive et répondent de manière hargneuse à toute attitude critique. Preuve qu’ils ne sont pas sûrs de leurs résultats ! Bref, les choses bougent. Heureusement !

C’est dans ce contexte d’incertitudes scientifiques qu’il faut pour le coup appliquer le vrai principe de précaution.

Les conséquences du réchauffement

Ce qui est surprenant c’est que, dans cette affaire, personne ou presque ne se préoccupe de savoir quelles seraient les conséquences précises d’un réchauffement moyen de deux degrés en un siècle, sachant que ce réchauffement serait fort aux pôles et nul à l’équateur. Aux pôles où la température varie entre -30 et -60 °C, l’augmentation de même 10 °C n’aura pas de conséquences catastrophiques. On accumule les inconvénients supposés, on n’analyse pas les conséquences positives éventuelles. Nulle part n’est fait un bilan sérieux.

Je ne crois pas que les Canadiens, les Ukrainiens ou les Norvégiens seront fâchés si les hivers sont moins rudes. Les rendements agricoles pourraient augmenter de 30 % par suite à la fois de l’augmentation des teneurs en CO2 et de la température.

Je ne crois pas non plus que les Français s’en plaindront, pour peu qu’il neige en montagne pour ne pas ruiner les stations de sports d’hiver !

Savez-vous que la température à Paris a augmenté de 2,5 °C en un siècle ? Qui s’en plaint (il y a plus de morts de froid l’hiver que de chaud l’été) ?

Les agriculteurs constatent que l’augmentation des teneurs en gaz carbonique de l’atmosphère est favorable à la pousse des plantes, et des arbres en particulier, ce que confirment les expériences des chercheurs de l’Inra (de 15 à 20 % suivant les espèces).

Les années « chaudes » du Moyen Âge ont été, semble-t-il, assez prospères pour l’agriculture. Tout cela, pour compenser le catastrophisme dont on nous rebat les oreilles tous les jours. Sans doute y aura-t-il des migrations d’espèces vivantes. Sans doute la situation de la faune arctique va-t-elle évoluer, mais faut-il décrire cela comme autant de catastrophes ?

En fait, les Nations unies avaient utilement créé un groupe chargé d’étudier les conséquences du réchauffement. Ce groupe a peu travaillé et est tombé bien vite dans l’ambiance catastrophiste imprimée par le groupe de synthèse. Mieux vaut ne pas en parler.

Comme nous l’avons dit, les changements climatiques seront largement locaux. Ils auront des aspects positifs et négatifs, et il faut faire un inventaire des deux. D’abord à l’échelon national ou continental. En donnant le leadership aux économistes, mais en impliquant aussi des agronomes, des écologistes aménageurs, des spécialistes de l’énergie et quelques scientifiques (pas des militants catastrophistes si possible). C’est à partir de ces travaux régionaux qu’on pourra dégager des tendances générales.

Ce travail reste à faire et pourtant il est essentiel ! Mais qu’on évite le ridicule de phrases comme celles-ci « C’est terrible, à cause du réchauffement nous avons eu un hiver très doux. » « Catastrophe, j’ai fait 2 000 euros d’économie sur ma facture de chauffage ! »

Quelles actions entreprendre ?

Pourtant, que ce soit ceux qui comme moi ont des doutes sur l’influence cardinale du gaz carbonique sur le climat, ou ceux qui calculent les modèles, nous sommes d’accord pour dire que les mesures que nous prendrons tout de suite n’agiront que dans cinquante ou cent ans.

Ron Prinn, du MIT, pourtant peut suspect de ne pas croire au GW, écrit :

« Les prévisions du GIEC montrent que les températures de notre planète et le niveau des mers ne seront pas contenus avant l’année 2100. Quel que soit le niveau de stabilisation du CO2 évoqué ci-dessus. La raison en est simple : une fois le niveau de CO2 stabilisé, il faut cent ou deux cents ans supplémentaires pour stabiliser la température océanique et le niveau des mers. »

Va-t-on déstabiliser l’économie mondiale pour une prédiction à une telle échéance ?

C’est comme si on vous proposait la stratégie suivante :

« Il faut passer rapidement au régime communiste, parce que le modèle économique, calculé avec les plus gros ordinateurs du monde, vous prédit la chute du régime capitaliste, qui en 2100 aura des taux de croissance négative de -1 à -5 %. »

À l’échelle du monde, ni la Chine, ni l’Inde, ni le Brésil, ni le Canada, ni les États-Unis n’envisagent des mesures qui brideraient leur croissance. Dans ces conditions, les prendre pour la France et quelques pays d’Europe serait une auto-flagellation. Et une punition économique sévère parce que nous vivons une époque de mondialisation, où la compétition économique est sans pitié. Pourquoi faudrait-il être seuls à se tirer une balle dans le pied ? Cela rejoindrait l’attitude de repentance que dénonce Pascal Brucknerlv.

Cette solution est à combattre sans faiblesse.

Que devons-nous faire, face au changement climatique ? C’est là la véritable question.

En fait, il existe trois types de réponses :

1) Réduire massivement et immédiatement les dégagements de CO2.

2) Contrôler la température du globe, en agissant à l’échelle globale, c’est l’option dite de la géo-ingénierie.

3) S’adapter au changement climatique sans modifier brutalement nos modes de production.

Je me situe pour ma part dans une quatrième option, qui est une combinaison des scénarios 3 et 1. S’adapter, tout en réduisant progressivement les émissions de CO2.

Examinons d’abord les deux scénarios qui aujourd’hui mobilisent la communauté écologique, les médias et donc les politiques (« Je suis leur chef, il faut bien que je les suive », disait Ledru-Rollin !).

1) Le scénario de réduction massive des émissions de CO2 est celui que préconisent les éco-fondamentalistes : réduction du transport aérien, de la circulation automobile, de l’activité industrielle et du chauffage domestique. Il conduirait à une crise économique majeure s’il était appliqué à l’échelle du monde, pour un résultat, possible mais non certain, dans cinquante ou cent ans.

2) À partir de l’« état de panique » planétaire actuel, certains proposent une stratégie radicalement opposée. Il faut que l’homme contrôle le climat, le module à sa guise. C’est ce qu’on appelle la géo-ingénierie.

Paul Crutzen, prix Nobel de chimie pour la découverte des mécanismes de la couche d’ozone, reprenant une proposition ancienne du Russe Budyko, veut que l’on injecte massivement des composés soufrés dans la stratosphère pour faire un bouclier thermique et refroidir la planète. Naturellement, une telle opération coûterait de l’argent. Il faudrait injecter 35 millions de tonnes de SO2 chaque année dans la stratosphère. Le coût évalué par Wallace S. Broeckerlvi serait de 20 milliards de dollars chaque année, ce qui n’est rien par rapport aux budgets militaires. Le mécanisme d’action supposée est le suivant : le SO2 réagit dans l’atmosphère avec l’eau pour donner de l’acide sulfurique dont les gouttelettes réfléchissent le rayonnement solaire. La question est bien sûr : que devient l’acide sulfurique ainsi formé ? En moins d’un an, il retombe sur le sol. Ainsi, on aurait refabriqué les pluies acides dont on a eu tant de mal à se débarrasser !

La seconde suggestion, plus douce, est de saupoudrer de fer l’océan. Ce fer stimulerait la production de phytoplancton et ainsi se produirait tout naturellement une absorption du CO2 par photosynthèse. Dans cet esprit, il faut noter que les engrais – nitrate et phosphate –, utilisés en quantités surabondantes, sont solubilisés par les eaux et rejoignent ensuite les fleuves, puis l’océan. Ils contribuent ainsi à alimenter l’océan en azote et phosphore qui sont les deux éléments essentiels pour la formation de matière vivante. La suppression des engrais aurait, à n’en pas douter, un effet négatif sur le développement du phytoplancton, tout comme la diminution des poussières industrielles contribue à diminuer la formation des nuages et donc à réchauffer l’atmosphère. Faut-il pour autant continuer à polluer nos rivières et nos nappes phréatiques, et à dégager des poussières dans les villes ?

Ces propositions sont à classer avec celle de l’homme démiurge. L’homme est assez puissant pour menacer les équilibres naturels, donc l’homme est assez puissant pour les contrôler ! L’homme est un dieu !

Aujourd’hui, heureusement, personne ne semble décidé à jouer les apprentis sorciers. Pourtant, ces technologies éviteraient d’avoir à limiter les émissions de CO2 et permettraient de mettre en place le scénario « Business as usual ».

Ces idées ressemblent à celles de certains de mes collègues qui, il y a quelques années, proposaient d’utiliser des bombes atomiques de moyenne puissance pour déclencher artificiellement des séismes (le projet avait retenu pour l’expérience la faille de Danali en Alaska) ou pour fracturer de gros réservoirs de pétrole afin d’en extraire la totalité du pétrole qu’ils contiennent !

3) La troisième solution est au premier abord la plus raisonnable. Il y a un changement climatique ? Quelle que soit sa cause, il faut s’adapter.

Ron Prinn lui-même ne dit pas autre chose :

« Je pense qu’en parallèle des discussions et actions concernant la réduction des émissions, de nombreuses actions préventives doivent êtres lancées ; l’adaptation est partie intégrante de la solution. »

Nigel Lawson, ancien chancelier de l’Échiquier de Grande-Bretagne, défend la même idéelvii. C’est aussi l’opinion de Wallace S. Broeckerlviii : « La réponse la plus rationnelle au changement climatique, quelles que soient ses raisons, est de s’y adapter ! »

Adaptation, c’est pour moi le maître mot de l’action. L’adaptation, c’est le propre de l’homme et même de la vie.

L’homme a su s’adapter, au cours de ses quatre millions d’années d’existence, aux changements climatiques, aux épidémies, à l’agression des bêtes sauvages, à la dureté de la nature. On l’a vu s’adapter à la menace du plomb dans l’essence, de la déchirure de la couche d’ozone, aux menaces des pluies acides. Il doit apprendre à s’adapter au changement climatique. Et c’est là la question essentielle.

Les dégâts d’un même tremblement de terre en Égypte et au Japon n’ont rien de comparable. L’homme sait prévenir même lorsqu’il ne sait pas prévoir. C’est donc un immense programme d’adaptation au changement climatique que l’homme doit entreprendre. Or, on n’en fait rien ou presque. C’est bien l’attitude de l’écologie dénonciatrice : on dénonce et, hors des solutions punitives, on ne fait rien ! Comme nous l’avons montré, ce changement climatique va être fortement modulé par la géographie « local change », mais avec un dénominateur commun, l’augmentation de la fréquence des phénomènes extrêmes. Chacun doit analyser sous toutes leurs formes les conséquences qu’aura le changement climatique, bien qu’on n’en connaisse pas exactement les modalités. C’est ce à quoi devraient s’attacher les gouvernements. Il faut réunir des groupes de travail pour préparer une adaptation à la fois positive et préventive, car, comme on l’a dit, beaucoup de conséquences se révéleront en fait bénéfiques.

Pour ce qui concerne la France, les menaces sont multiples. Sans être exhaustif, on peut énumérer :

— les tempêtes et leurs effets désastreux sur les côtes atlantiques et le nord du pays,

— les inondations dont la fréquence augmente et va peut-être même s’accélérer,

— le manque d’eau l’été. Il faudra arbitrer entre consommation et arrosage,

— les vagues de chaleur et de froid,

— les glissements de terrain en montagne, consécutifs aux orages violents,

— des problèmes d’enneigement pour les stations de sports d’hiver,

— la question de l’interdiction actuelle d’arroser des vignobles qui deviendra pénalisante en cas de sécheresses à répétition.

Pour chacune de ces menaces, et à condition de le faire dans la durée, des actions préventives sont possibles.

Citons-en quelques-unes :

— enterrer les lignes à haute tension, en priorité dans les zones côtières,

— développer un programme de prévention des inondations, cela veut dire construire des digues solides sur le Rhône, définir les zones inondables, mais aussi diminuer le ruissellement en plantant des feuillus, en goudronnant à l’aide de goudrons et ciments poreux, en perforant les sols argilisés pour permettre à l’eau de s’infiltrer, en draguant les sédiments déposés dans les fleuves,

— injecter en hiver de l’eau dans les nappes phréatiques qu’on récupérerait en été, comme on le fait déjà au Moyen-Orient. C’est un nouveau secteur industriel à développer,

— mettre au point par génie génétique des plantes résistant à la sécheresse,

— mettre en place, à l’aide des satellites, un observatoire des glissements de terrain en montagne relié à un réseau d’alertes,

— renforcer les moyens d’enneigement artificiel pour les sports d’hiver, etc.

Mais là où je me distingue de la solution purement adaptative, c’est que je crois que nous devons de plus prendre des mesures efficaces, mais progressives, pour réduire les émissions de CO2 (et économiser le pétrole). Nous les développerons au chapitre suivant.

Je pense et je répète que les émissions de CO2 ne sont pas une bonne chose pour l’atmosphère et surtout pour l’océan. Bien que mon expérience de géochimiste me fasse penser que tôt ou tard la courbe d’augmentation s’infléchira et tendra vers une limite (comme tout système naturel, qu’il soit perturbé par l’homme ou pas). Mais comme je ne sais pas quand cela aura lieu et que je n’ai pour l’instant aucune indication fiable pour le prévoir, nous devons agir dans le cadre d’une augmentation sans régulation naturelle.

L’urgence pour la France et l’Europe, ce n’est pas la réduction soudaine des émissions de CO2 car le prix à payer sur le plan économique et social serait trop grand. D’autant plus qu’on n’a aucune indication sur l’attitude future des États-Unis, de la Chine et de l’Inde. Nous devons donc prendre des mesures de restriction progressive qui auraient des impacts sociétaux faibles et qui si possible stimuleraient la croissance au lieu de la freiner ; nous devons soutenir l’intelligence, l’innovation – bref choisir des solutions qui permettent de conjurer rationnellement les dangers.

Dans ce cadre et contrairement à la solution Hulot (réduction des trois quarts des émissions de CO2 en dix ans), la proposition de la Commission européenne de réduire les émissions de CO2 de 20 % en vingt ans est à mon avis une excellente proposition à laquelle j’adhère.